Da bei neuen Projektoren immer wieder die Gamutabdeckung besprochen wird und dieser Wert von einigen enorm hoch gehalten wird, wollte ich seit längerem mal untersuchen, wie sichtbar dieser Parameter überhaupt ist. Und das im Verhältnis zu einer höheren Leuchtdichte. Häufig tauscht man ja das eine gegen das andere, indem ein Filter in den Lichtweg geschoben wird. Da von mehr Licht dank Stevens- und Hunt-Effekt alle Farben und sogar Schwarzweißbilder profitieren, würde ich einfach gerne mal wissen, wie viel Licht man gegen mehr Gamut eintauschen kann, bis der Nutzen die Nachteile überwiegt und umgekehrt.

Die Idee ist einfach: man kann beides auf digitalem Wege simulieren, indem man die Werte nicht vergrößert, sondern verkleinert. Die Helligkeit auf einen definierten Weg zu reduzieren, hatte ich ja mit dem Bildparametersimulator bereits gemacht. Das ist eine Kleinigkeit. Beim Farbraum hatte ich bis bisher keine Lösung parat. Gestern bin ich allerdings auf diese Seite gestoßen. Dort kann man zwei 3D-LUTs quasi konkatenieren. Ich mache also folgendes:

- Synthetisches ICC-Profil für kleinen Farbraum erzeugen

- 3D-LUT erzeugen: großer Farbraum -> kleiner Farbraum (Clipping auf den äußeren Grenzen)

- 3D-LUT erzeugen: kleiner Farbraum -> großer Farbraum (Farben außerhalb des kleinen existieren nicht, alle innerhalb werden korrekt dargestellt)

- LUTs aus 2. und 3. konkatenieren und neue 3D-LUT erzeugen

Wenn man die resultierende 3D-LUT z.B. in einem Player oder auf dem Desktop anwendet, dann werden alle Farben innerhalb des kleinen Farbraums unverändert dargestellt. Die Farben außerhalb werden allerdings auf seine Grenzen gelegt. Das heißt, man kann dann auf demselben Zielgamut mit derselben Kalibrierung per Knopfdruck vergleichen. Dieser Satz ist essentiell wichtig, denn hier umgehen wir die größten Fehlerquellen, wenn man z.B. am Projektor oder im Videoprozessor verschiedene Profile umschaltet. Farbtemperatur und Gamma bleiben konstant.

Ich habe das mal mit BT.709 als Quellfarbraum durchgeführt. Einfach deswegen, weil das jeder an seinem Monitor darstellen kann. Man kann das natürlich auch mit DCI-P3 oder BT.2020 machen. Das ist prinzipiell völlig egal.

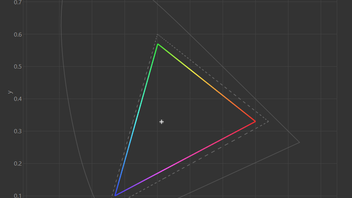

Ich habe hier also zwei kleine Gamuts. Einmal mit 75 % und einen mit 50 % Abdeckung bezogen auf BT.709. Die Sättigung der Primärfarben wurden dabei ungefähr gleich stark reduziert (ich habe die Koordinaten frei gewählt). Die Abdeckung bezieht sich auf das Volumen, nicht auf die Fläche.

75 % BT.709:

50 % BT.709:

Natürlich habe ich die resultierenden 3D-LUTs auch messtechnisch validiert. Die Sättigungsverläufe waren wie erwartet (hier nicht gezeigt).

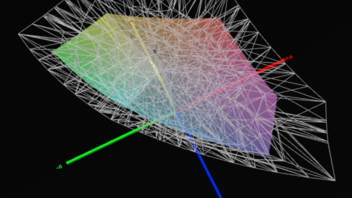

Das Ganze kann man sich übrigens auch in 3D anschauen:

Nun kann man diverse Screenshots aus Filmen erstellen und z.B. 50 % weniger Gamut 50 % weniger Leuchtdichte gegenüberstellen usw. Das ist natürlich alles entsprechend aufwändig. Hier mal ein Beispiel:

50 % Gamut:

50 % Leuchtdichte:

75 % Gamut:

75 % Leuchtdichte:

Man kann hier pro Beitrag immer nur 10 Bilder reinstellen, daher muss ich hier stark reduzieren.

Hier noch mal ein Realbild, um mal ein Gefühl dafür zu bekommen, wie viel 50 % (!) weniger Farbraum eigentlich ausmachen. Man sieht hier schön, dass das rote Kleid betroffen ist und ein bisschen der Himmel und ein paar gelbe Bäume. Der Rest sieht nahezu identisch aus. Und 50 % sind schon enorm viel!

100 % Gamut:

50 % Gamut:

Das Prinzip funktioniert jedenfalls und die Unterschiede sind teilweise sehr gering. Das hatte ich auch immer so erwartet. Stark gesättigte Farben kommen eben nicht so oft vor. Dagegen wirkt die Leuchtdichte regelrecht brachial auf das gesamte Bild. Sowohl in die eine als auch in die andere Richtung. Das ist im Grunde alles nicht neu, aber es gibt keine objektiven Zahlen, mit denen man argumentieren könnte. Das fehlt uns leider komplett und müsste erarbeitet werden.

Ich will daher auch kein voreiliges Fazit ziehen, dafür müsste man mehr Zeit reinstecken und systematischer Vergleichen. Der Grundstein ist jedenfalls gelegt. Ich kann gerne 3D-LUTs veröffentlichen, wenn gewünscht. Derzeit allerdings nur im CUBE-Format. Ich weiß nicht, ob es Converter nach 3dlut (madVR/Envy) gibt.

Vielleicht habt ihr ja Szenen, die ihr gerne mal untersucht haben wollt. Meldet euch einfach. Und Diskussionen sind natürlich gerne willkommen.